以下文章来源于技术领导力 ,作者Mr.K

尤瓦尔·赫拉利在《人类简史》有句名言:“我们从农业革命能学到的最重要一课,很可能就是物种演化上的成功,并不代表个体的幸福。”同样,AI革命会给我们带来更多个体的幸福吗?这也是一个值得思考的大命题,但不管怎么说,AI已来,我们最应该做的,还是了解它、掌握它,并努力“驯化”它。

- 文章信息 -

本文作者:Mr.K,黄哲铿,企业数字化转型专家,「顿悟山丘」创始人,科技博主,曾担任海尔、中通快递、1药网技术高管,著有《技术人修炼之道》《技术管理之巅》。分享:个体成长、科技趋势、数字化转型、商业洞察。由「技术领导力」原创首发, 数字化企业经授权发布。

1

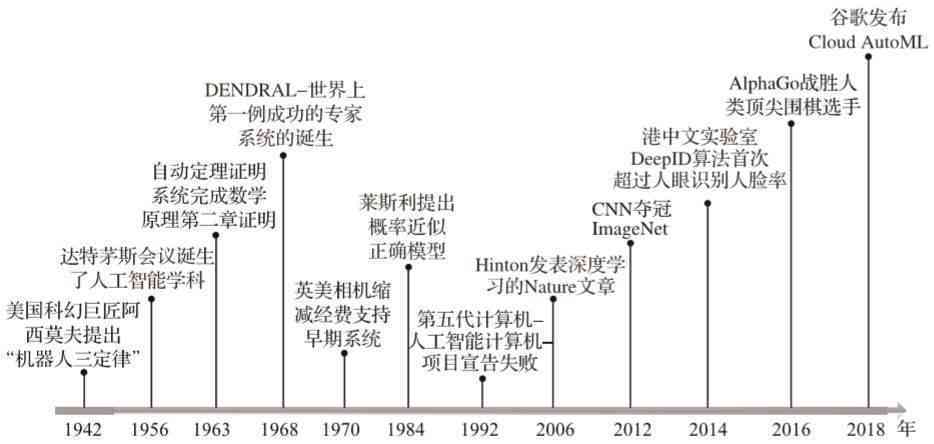

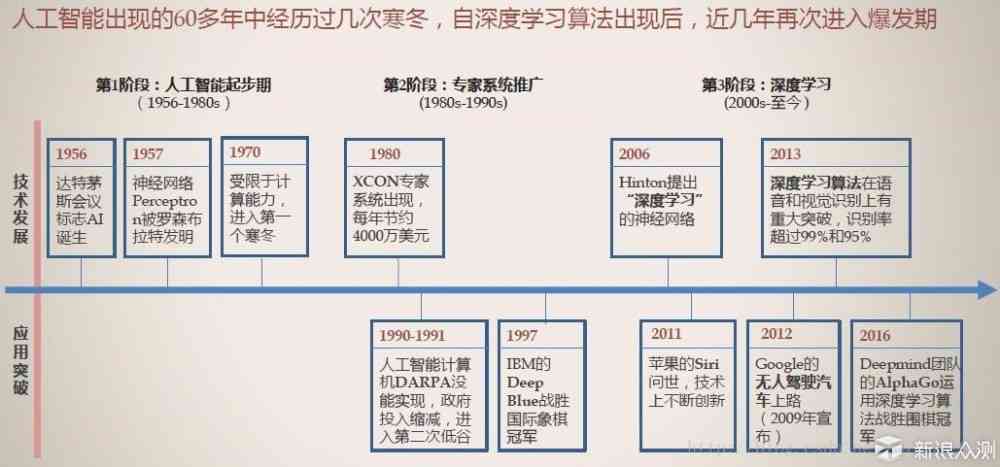

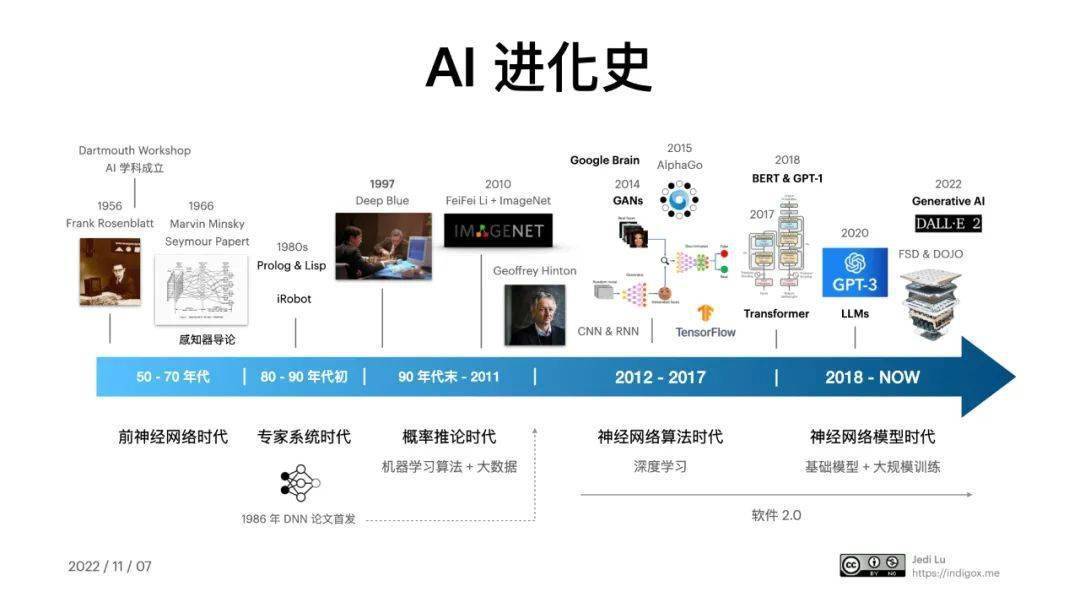

萌芽期:人工智能兴起

“机器会思考吗?”英国天才数学家、逻辑学家、密码学家、计算机科学家艾伦.图灵,在1950年发表的经典之作《计算机和智能》一文中,提出了这个科技史上颇具哲学色彩的著名问题。图灵为找寻答案,付诸了实践,开展了旨在验证计算机是否具备人类智能的“图灵测试”。在这个著名的实验中,测试者被要求判断与自己交谈的是人类还是计算机,如果计算机能够“骗”过测试者,让测试者以为自己是人类,那就代表计算机通过了图灵测试,否则就是失败。虽然图灵测试,并未解决图灵的哲学之问,但它却成了后世研究人工智,所绕不开的起点和重要基石。

艾伦.图灵by AI

在图灵测试出现后的第6年,约翰·麦卡锡、马文·明斯基、克劳德·香农、艾伦·纽厄尔和赫伯特·西蒙等一众大神,在达特茅斯学院召开了“人工智能暑期研讨会”。在这次会议中,科学家们首次明确提出了“人工智能”这一用语,并对人工智能的未来发展充满憧憬,有人甚至认为,机器人和AI能在1970年代中期完成人类的工作。虽然事实证明,大佬们乐观的预言并没有实现,但这丝毫不影响达特茅斯会议在人工智能发展史上,不可取代的历史地位。正是这次会议,标志着人工智能作为一门新兴学科正式诞生。

在这一时期,AI的发展隐隐形成了符号主义(symbolistic)、连接主义(connectionist)和行为主义(actionism)三大流派的雏形,但当时最主流的研究,还是集中在逻辑推理、符号主义上。研究人员试图用逻辑规则和符号来模拟人类的思维过程。通过物理符号系统假设,来构建能够模拟思维的计算模型。以美国卡内基-梅隆大学的艾伦·纽厄尔、赫伯特·西蒙为代表的学者,开发了诸如"逻辑理论家"(Logic Theorist)、"通用问题解决器"(General Problem Solver)等早期人工智能系统,旨在模拟人类智能的推理和决策过程。这些“初代”人工智能程序,虽然在应用和推广上,存在很大的局限性,但还是展现了人工智能在解决逻辑和抽象问题上的巨大潜力,为AI进一步发展奠定了基础。

2

发展期:神经网络

20世纪80年代,机器学习开始崭露头角。随着计算机性能的提升和数据量的增加,人们开始关注如何让计算机模仿人脑的学习能力。这一时期,神经网络作为一种模仿生物神经元工作方式的计算模型,慢慢形成气候。事实上,这种模仿人脑结构和信息处理机制的计算模型,正是上面提到的AI“连接主义”的代表。

由于计算能力大幅提升等各种主客观条件的不断完善,科学家们得以搭建起更加复杂的神经网络架构,从而使神经网络在模式识别、分类任务(人脸识别、物体检测、理解和处理自然语言、通过分析用户行为模式进行个性化推荐和反欺诈等)等方面,得到广泛应用。

在这一研究领域,杰弗里.辛顿(Geoffrey Hinton)无疑是最具代表性的人物之一,他深入研究了使用神经网络进行机器学习、记忆、感知和符号处理的方法,并前后发表了超过200篇论文,被称为“神经网络之父”、“深度学习之父”。

杰弗里.辛顿

杰弗里.辛顿出生在“科研世家”,家族成员大都是科学家或教授,其曾曾祖父乔治·布尔(George Boole),更是二进制推理系统(即现在的布尔代数/逻辑代数,是所有计算的基础)的发明者。辛顿本身也是一个妥妥学霸,18岁的辛顿进入剑桥大学国王学院学习物理、化学和数学,坚持1个月后退学,第二年,又改修建筑学,仅仅坚持1天,这位任性的天才又转学哲学,同样半途而终后,才转学物理和生理学。

学生理学的原因,是因为教授告诉他这门科学可以让大家明白大脑是如何工作的,而这恰恰是辛顿最感兴趣的。但当辛顿顺利拿到心理学学位后,又觉得自己所学的东西太简单了,根本不足以解释大脑的运作,于是在失望无聊之际,放弃了在剑桥大学继续学习的机会,竟然任性地做起了木匠。辛顿一边打木门一边思考大脑的运作,坚持了一年多后,又重新回归学术圈,并确定了一个新的研究方向,人工智能。

这个领域也彻底治好了辛顿的“学习过动症”,让他沉下心来深耕下去,并开创性的打破了AI符号主义的“桎梏”,颠覆了明斯基等大佬权威的理论,让神经网络研究大放异彩。他与其他两位科学家一起,将反向传播算法(BP)应用于多层神经网络,并由此证明这种方法对机器学习的有效性。此外,辛顿还发明了对比散度算法,用于训练玻尔兹曼机(Boltzmann Machine)。辛顿的这些贡献,对深度学习的进步产生了深远影响,他开创的算法和理论,也为后来者理解神经网络和训练深度模型提供了重要工具和抓手。

3

突破期:深度学习

自2000年以后,深度学习技术取得了巨大突破。这一技术通过多层神经网络的训练,能够自动从大量数据中提取特征,从而显著提升了图像识别、语音识别和自然语言处理等领域的性能。在深度学习的发展中,卷积神经网络(CNN)、循环神经网络(RNN)和长短期记忆网络(LSTM)等技术起到了重要作用。

1、卷积神经网络(CNN)

卷积神经网络(Convolutional Neural Networks,简称CNN)是深度学习在计算机视觉领域的代表性成果,其设计灵感来自于生物学中视觉皮层的工作原理,这一领域的领军人物就是图灵奖得主、被称为“卷积之父”的Yann LeCun(杨立昆)。

Yann LeCun(杨立昆)

Yann LeCun从20世纪80年代开始研究神经网络技术,并提出了卷积神经网络这一革命性架构。与传统的全连接神经网络不同,卷积神经网络巧妙地利用了图像数据的局部相关性,通过在网络中设计卷积和池化等操作,能够自动从图像中提取各种复杂特征。这使得CNN在图像分类、目标检测等任务上,取得了大幅度的性能提升。

卷积神经网络到底有多重要?从最近Yann LeCun与马斯克隔空互怼的事件中,也能看出一二来。最近,马斯克为他新成立的xAI公司,在社交平台X上招募人才,Yann LeCun留言讽刺,痛批马斯克对AI风险的无限夸大和对技术进步的盲目乐观。马斯克反击“过去五年你做了哪些研究?”。Yann LeCun的“回敬”之一,就是自己当初发表的关于卷积神经网络的研究成果,“至今仍然被包括特斯拉、MobilEye、Nvidia在内的几乎所有高科技公司所使用”,换句话说, 你马斯克的特斯拉,就是靠我的技术理论搞起来的。谁说科学家不会吵架,Yann LeCun就很懂杀人诛心嘛。

2、循环神经网络(RNN)与长短期记忆网络(LSTM)

除了卷积神经网络,循环神经网络(RNN)和长短期记忆网络(LSTM)也在深度学习中发挥着重要作用。这些网络结构能够有效地建模语音、文本等时序数据,在语音识别、机器翻译、对话系统等领域取得了革命性的进步。

RNN的核心在于它能够在处理当前输入的同时,还能保留之前的历史信息,从而更好地理解和预测序列数据。而LSTM则是在此基础上进一步改进,通过引入记忆单元,能够更好地捕捉长期依赖关系,从而在语言建模等任务上,取得了显著的性能提升。

由于序列数据处理在语音识别和自然语言处理等领域具有广泛应用,RNN和LSTM成为了这些领域的关键技术。谷歌、微软等科技巨头纷纷在这些领域,投入大量研发资源,利用RNN和LSTM相关的技术,打造出了各种智能语音助手和对话系统,为用户提供了更加自然、流畅的交互体验。

4

爆发期:大模型

近10多年来,随着计算能力和数据资源的进一步提升,大规模预训练语言模型(LLM)逐渐成为人工智能研究的热点,而生成式预训练模型GPT(Generative Pre-trained Transformer)更是成了众人皆知的“显学”。通过在海量文本数据上进行预训练,GPT模型能够学习到丰富的语言知识和语义理解能力,从而在问答、对话、文本生成等自然语言处理任务上取得了前所未有的成就。

在这一发展进程中,OpenAI的联合创始人伊利亚.苏茨克维(Ilya Sutskever) 起到了举足轻重的作用。伊利亚出生于俄罗斯,师从杰弗里·辛顿。在大学期间,伊利亚曾与辛顿的另一位学生一起,开发了卷积神经网络AlexNet,并在当年的ImageNet挑战赛中勇夺冠军,其精确度更是遥遥领先,是第二名的两倍。AlexNet的成功,除了体现了大型神经网络面对大规模数据时的巨大潜力,还有力地证明了GPU在大型神经网络训练中的高效性,对后面GPU的发展,以及OpenAI的技术发展走势,都起到了极为重要的影响。

伊利亚.苏茨克维

大学毕业后,伊利亚加入了辛顿创立的DNNResearch公司,其后该公司被谷歌收购,他加入谷歌,成为谷歌大脑的研究科学家。直到2015年,伊利亚被马斯克从谷歌挖走,和山姆·奥特曼等人,共同创办了OpenAI。伊利亚担任OpenAI的首席科学家。

在OpenAI,伊利亚几乎主导了所有关于GPT的研发,但随着OpenAI的发展,原本奥特曼主外,伊利亚主内的稳定格局,慢慢出现了问题。其中最主要的原因之一,就是两人所持有的“有效加速主义”和“超级对齐主张”之间难以调和的矛盾。所谓“有效加速主义”,就是推崇科技的不断发展和颠覆,认为可以不完美,但不能不发展。而“超级对齐主张”,则是要确保人工智能的发展,要与人类价值观保持一致,否则宁愿停止发展。伊利亚持有的观点是后者,他和恩师辛肯一样,非常在意超级对齐,并组建了OpenAI的超级对齐团队。

但奥特曼却是一个务实主义者,更在乎“有效加速”和商业上的发展。最终两人矛盾越来越严重,以至于发生了伊利亚“政变”,把奥特曼从OpenAI踢出局的戏。但最终还是上演了奥特曼强势回归,伊利亚却选择离职出走的反转剧情。但不管从哪个角度来说,作为AI领域的顶级科学家和践行者,伊利亚都值得这个时代敬仰。

尤瓦尔·赫拉利在《人类简史》有句名言:“我们从农业革命能学到的最重要一课,很可能就是物种演化上的成功,并不代表个体的幸福。”同样,AI革命会给我们带来更多个体的幸福吗?这也是一个值得思考的大命题,但不管怎么说,AI已来,我们最应该做的,还是了解它、掌握它,并努力“驯化”它。