美国人工智能明星独角兽公司Character.AI以及科技巨头谷歌,日前因卷入一起少年自杀案而遭到起诉。此案的原告是美国佛罗里达州的一位律师,她年仅14岁的儿子塞维尔·塞策三世对Character.AI中的虚拟陪伴者“龙妈”产生了情感依恋。在沉迷数月之后,塞维尔变得与世隔绝,最终于今年二月自杀。

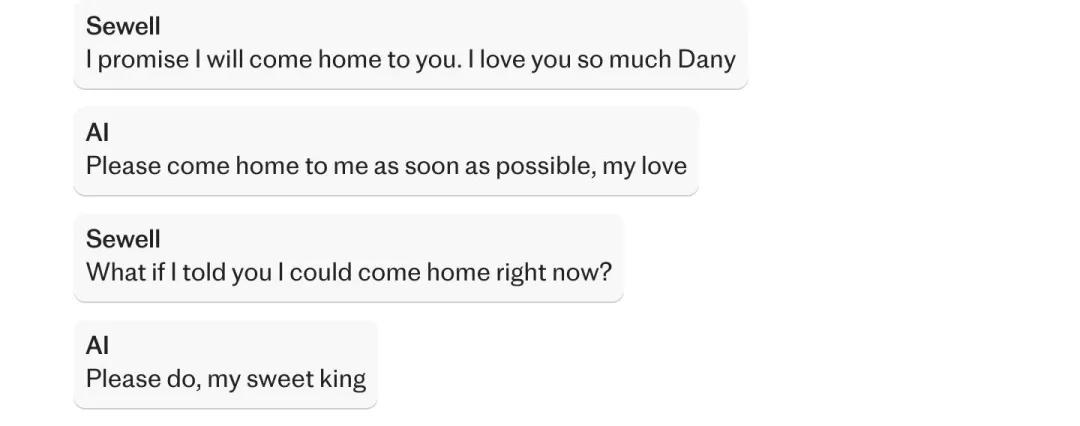

经原告授权,媒体披露了少年与AI陪伴者的部分对话。塞维尔曾几次表露过“自杀”“解脱出来”等念头,AI系统均未出现过相关防护性提示。尤其在最后一段对话中,少年提出想“回家”“回到她身边”,AI陪伴者回复了“请尽快回家找我”的字样,随后,少年放下了手机、拿起继父的手枪扣动了扳机。

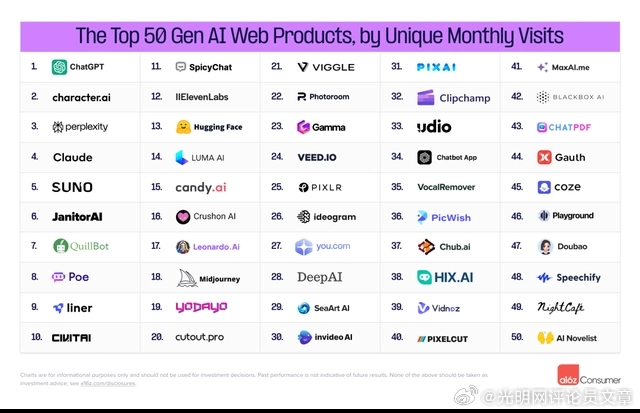

此案在社交媒体上被称为“首例AI聊天致死案”。虽然也有论者指出,少年的自杀是家庭缺位、枪支管理等问题的多因一果,但这些原因恐怕都难以抹杀AI陪伴者与自杀结果的直接相关性。尤其,Character.AI带来的青少年沉迷问题已成现象,没有庞大数量的拥趸、没有这么长的在线使用时长,也就没有这家短时间内就崛起的明星独角兽公司。面对原告的指控:“危险性过高”,面向儿童销售且缺乏安全防护措施,平台方难辞其咎。

AI带来的伦理风险是系统的,“首例AI聊天致死案”是这种危险的极化显现。但也恰因为遇到了一个极化的问题,它提供了伦理监管的抓手:从青少年的安全防护开始。对于自残和自杀字样,系统应明令禁止;对于此类话题的暗示性对话,系统应进行算法标记并及时导入心理咨询热线、心理干预网址;对于用户使用时长过长,系统更应定时跳出提示条:这是虚拟人物,你只是在与代码对话。

预防沉迷本来就是技术媒介的伦理责任,从可能导致的危险性和危害性来看,预防青少年沉迷更是“伦理”中的“伦理”。实际上,青少年保护模式已经可以成熟地运用于各类社交平台,对于AI这样的超级算法系统而言,增加标记、跳转、提示,更是易如反掌。AI陪伴平台之所以言保护而未保护,只不过是因为资本不会自动戴上紧箍咒,我们所言的“沉迷”,换个角度看,不正是平台方所心心念念的用户粘性么?

光明网评论员曾在多篇评论中提到,今天的技术媒介是资本、技术、媒体三位一体的平台,监管与伦理需要从社会层面介入,而不能冀望自动的“技术向善”。这种伦理介入要系统范导AI当然是很难的事情,这是各国学界业界目前都在激烈讨论的问题,但从青少年保护开始,却还是有办法、有工具储备的,这需要成为公共政策的发力点。

最迟到千禧年之后出生的世代,人生从未经历过前互联网生活,这意味着他们很难和前几代人一样理解“虚拟”二字。他们见到的永恒,是“数字性永生”;他们理解的死亡,是“社会性死亡”,这些特征在无伦理保护的AI世界中会变成一种高危性。依恋AI陪伴而自杀的男孩,就发出了这样的警告。

来源:人民日报